글로벌 AI 서버용 HBM 칩 시장이란 무엇인가요?

글로벌 AI 서버용 HBM 칩 시장은 인공지능(AI) 서버용으로 특별히 설계된 고대역폭 메모리(HBM) 칩의 생산 및 유통에 중점을 둔 전 세계 산업을 지칭합니다. 이러한 칩은 복잡한 계산과 대용량 데이터 세트를 효율적으로 처리하기 위해 고속 데이터 처리 기능이 필요한 AI 서버의 핵심 구성 요소입니다. HBM 칩은 높은 데이터 전송 속도와 낮은 전력 소모로 유명하여 빠른 데이터 처리와 에너지 효율을 요구하는 AI 애플리케이션에 이상적입니다. 이 시장에는 HBM2, HBM2E, HBM3, HBM3E 등 다양한 유형의 HBM 칩이 있으며, 각 칩은 서로 다른 수준의 성능과 기능을 제공합니다. AI 기술이 지속적으로 발전하고 다양한 산업에 더욱 통합됨에 따라 AI 서버용 HBM 칩 수요는 크게 증가할 것으로 예상됩니다. 이 시장은 의료, 금융, 자동차 등의 분야에서 머신 러닝, 딥 러닝, 데이터 분석과 같은 AI 워크로드를 지원할 수 있는 강력한 컴퓨팅 솔루션에 대한 수요가 증가함에 따라 성장하고 있습니다. AI 서버용 글로벌 HBM 칩 시장은 AI 개발 및 기술 혁신의 광범위한 트렌드를 반영하며 역동적이고 빠르게 발전하는 산업입니다.

HBM2, HBM2E, HBM3, HBM3E, AI 서버 시장용 글로벌 HBM 칩의 기타 제품:

HBM2, HBM2E, HBM3 및 HBM3E는 고대역폭 메모리(HBM) 기술의 여러 세대로, 각각 이전 세대에 비해 고유한 기능과 향상된 기능을 제공합니다. 2세대 HBM인 HBM2는 기존 HBM에 비해 대역폭과 용량 측면에서 상당한 향상을 제공합니다. 더 빠른 데이터 전송 속도와 향상된 에너지 효율을 제공하여 AI 서버를 포함한 고성능 컴퓨팅 애플리케이션을 지원하도록 설계되었습니다. HBM2의 진화된 버전인 HBM2E는 메모리 대역폭과 용량을 더욱 증가시켜 까다로운 AI 워크로드에 더욱 적합합니다. 더 빠른 데이터 전송 속도와 더 큰 메모리 크기를 제공하여 AI 서버가 더 큰 데이터 세트를 처리하고 복잡한 계산을 더욱 효율적으로 수행할 수 있도록 지원합니다. 3세대 HBM인 HBM3는 성능과 기능 측면에서 상당한 도약을 보여줍니다. HBM2E보다 더 높은 대역폭과 용량을 제공하여 최고의 데이터 처리 능력이 필요한 차세대 AI 서버에 이상적입니다. HBM3의 향상된 버전인 HBM3E는 경계를 더욱 넓혀 전례 없는 수준의 성능과 효율성을 제공합니다. HBM은 가장 까다로운 AI 애플리케이션의 요구를 충족하도록 설계되었으며, 최고 수준의 데이터 전송 속도와 최대 메모리 용량을 제공합니다. 이러한 HBM 기술의 발전은 머신 러닝, 딥 러닝, 데이터 분석과 같은 AI 애플리케이션에 필수적인 대용량 데이터 세트를 더욱 빠르고 효율적으로 처리할 수 있도록 해주므로 AI 서버 개발에 매우 중요합니다. HBM 기술의 지속적인 발전은 기업들이 AI를 활용하여 인사이트를 얻고, 의사 결정을 개선하고, 혁신을 추진하고자 함에 따라 AI 산업에서 고성능 컴퓨팅 솔루션에 대한 수요가 증가하고 있음을 보여줍니다. AI 기술이 계속 발전함에 따라 AI 서버에서 HBM 칩의 역할이 점점 더 중요해지고 있으며, 이는 이 분야의 혁신과 발전을 더욱 가속화할 것입니다.

CPU+GPU 서버, CPU+FPGA 서버, CPU+ASIC 서버 등 글로벌 AI 서버용 HBM 칩 시장:

다양한 서버 구성에서 글로벌 AI 서버용 HBM 칩이 사용되는 것은 현대 컴퓨팅 환경에서 이러한 구성 요소의 다재다능함과 중요성을 보여줍니다. CPU+GPU 서버에서 HBM 칩은 AI 애플리케이션에 필요한 병렬 처리 작업을 처리하는 데 필수적인 그래픽 처리 장치(GPU)의 성능 향상에 중요한 역할을 합니다. HBM 칩의 높은 대역폭과 낮은 지연 시간은 GPU가 대용량 데이터를 빠르고 효율적으로 처리할 수 있도록 하여 이미지 및 음성 인식, 자연어 처리, 기타 AI 기반 워크로드와 같은 작업에 이상적입니다. CPU+FPGA 서버에서 HBM 칩은 유연성과 특정 작업에 대한 맞춤 설정 기능으로 유명한 FPGA(Field-Programmable Gate Array)를 보완하는 데 사용됩니다. HBM 칩과 FPGA를 결합하면 AI 애플리케이션의 특정 요구 사항에 맞춰 조정할 수 있는 매우 효율적이고 적응력 있는 컴퓨팅 솔루션을 구축할 수 있습니다. 이는 특히 금융 및 통신과 같이 변화하는 요구 사항에 신속하게 적응하는 능력이 중요한 산업에서 유용합니다. CPU+ASIC 서버에서 HBM 칩은 특정 작업에 맞게 설계되고 높은 성능과 효율성을 제공하는 ASIC(Application-Specific Integrated Circuit)과 함께 사용됩니다. HBM 칩과 ASIC을 통합하면 실시간 데이터 처리 및 복잡한 시뮬레이션과 같이 가장 까다로운 AI 워크로드를 처리할 수 있는 강력한 컴퓨팅 솔루션을 구축할 수 있습니다. 이는 특히 자동차 및 의료와 같이 대량의 데이터를 빠르고 정확하게 처리하는 능력이 필수적인 산업에서 중요합니다. 다양한 서버 구성에서 HBM 칩의 다재다능함은 광범위한 AI 애플리케이션을 지원하는 데 필요한 고속 데이터 처리 기능을 제공하므로 AI 산업에서 HBM 칩의 중요성을 강조합니다. AI 기술이 지속적으로 발전함에 따라 AI 서버에서 HBM 칩의 역할은 점점 더 중요해질 것이며, 이는 이 분야의 혁신과 발전을 더욱 촉진할 것입니다.

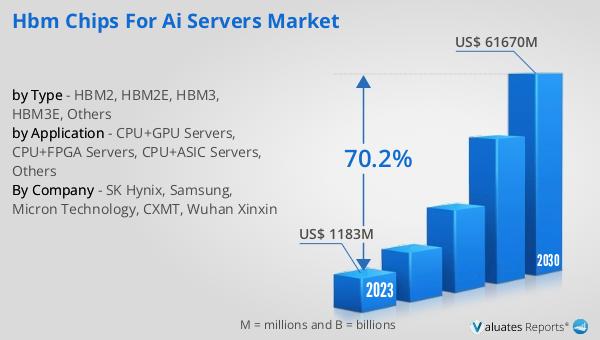

글로벌 AI 서버용 HBM 칩 시장 전망:

2024년 글로벌 AI 서버용 HBM 칩 시장 규모는 약 25억 3,700만 달러였습니다. 이 시장은 상당한 성장을 거듭하여 2031년에는 약 1,006억 3,000만 달러 규모에 이를 것으로 예상됩니다. 이러한 놀라운 성장세는 예측 기간 동안 연평균 성장률(CAGR) 70.2%로 예상됩니다. 이러한 놀라운 성장 궤적은 AI 산업에서 고성능 컴퓨팅 솔루션에 대한 수요가 증가하고 있음을 보여줍니다. AI 기술의 급속한 발전과 의료, 금융, 자동차 등 다양한 분야로의 통합은 복잡한 AI 워크로드를 지원할 수 있는 강력한 컴퓨팅 솔루션에 대한 수요를 촉진하고 있습니다. 높은 대역폭과 낮은 전력 소비를 갖춘 HBM 칩은 이러한 요구를 충족하는 데 이상적이며, AI 서버의 핵심 구성 요소입니다. 기업들이 인사이트 확보, 의사 결정 개선, 혁신 추진을 위해 AI 기술에 지속적으로 투자함에 따라 HBM 칩 수요는 크게 증가할 것으로 예상됩니다. 이러한 성장은 HBM 기술의 지속적인 발전으로 더욱 가속화되고 있으며, HBM2, HBM2E, HBM3, HBM3E와 같은 기술들은 더욱 향상된 성능과 기능을 제공합니다. AI 서버용 HBM 칩의 글로벌 시장은 AI 개발 및 기술 혁신의 전반적인 트렌드를 반영하며 역동적이고 빠르게 발전하는 산업입니다.

| 보고서 지표 | 세부 정보 |

| 보고서 이름 | AI 서버용 HBM 칩 시장 |

| 연간 시장 규모 | 25억 3,700만 달러 |

| 2031년 예상 시장 규모 | 1조 6,300만 달러 |

| CAGR | 70.2% |

| 기준 연도 | 연도 |

| 예측 연도 | 2025 - 2031 |

| 유형별 |

|

| 애플리케이션별 |

|

| 지역별 생산량 |

|

| 지역별 소비량 |

|

| 작성자 회사 | SK 하이닉스, 삼성, 마이크론 테크놀로지, CXMT, 우한 신신 |

| 예측 단위 | 백만 달러 가치 |

| 보고서 범위 | 매출 및 판매량 예측, 회사 점유율, 경쟁 환경, 성장 요인 및 추세 |

댓글 없음:

댓글 쓰기